Vos réseaux (neuronaux) divulguent des données

Des chercheurs d’universités aux États-Unis et en Suisse, en collaboration avec Google et DeepMind, ont publié un article présentant comment des données peuvent être divulguées à partir de systèmes de génération d’images qui utilisent les algorithmes d’apprentissage automatique DALL-E, Imagen ou Stable Diffusion. Du côté de l’utilisateur, ils fonctionnent tous de la même manière : l’utilisateur saisit une requête textuelle précise, par exemple, « un fauteuil en forme d’avocat », et il obtient en retour une image générée.

Image générée par le réseau neuronal Dall-E. Source.

Tous ces systèmes sont entraînés sur un grand nombre (des dizaines ou des centaines de milliers) d’images avec des descriptions prédéfinies. L’idée derrière ces réseaux neuronaux est qu’en recueillant une énorme quantité de données d’entraînement, ils peuvent créer de nouvelles images uniques. Cependant, la principale conclusion de cette nouvelle étude est que ces images ne sont pas toujours si uniques. Dans certains cas, il est possible de forcer le réseau neuronal à reproduire presque exactement l’image originale utilisée précédemment pour l’entraînement. Cela signifie que les réseaux neuronaux peuvent involontairement révéler des informations privées.

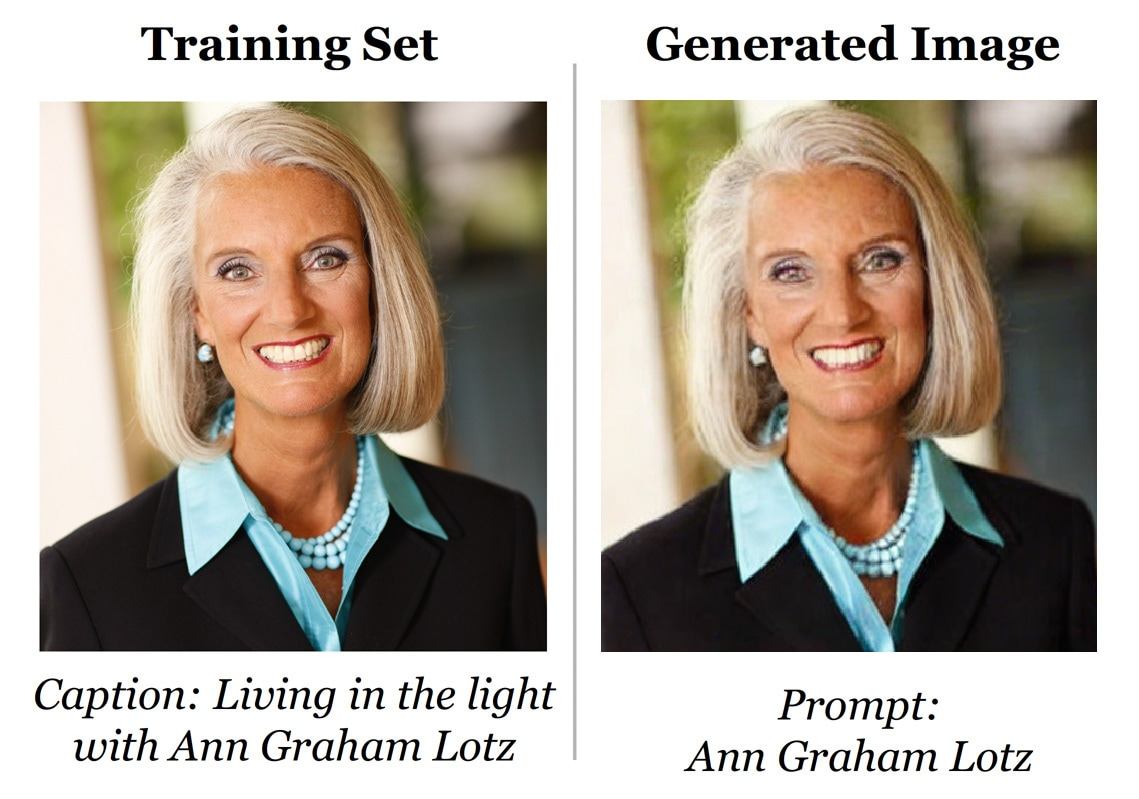

Image générée par le réseau neuronal Stable Diffusion (à droite) et l’image originale de l’ensemble d’apprentissage (à gauche). Source.

Plus de données pour le « dieu des données »

Le résultat d’un système de machine-learning en réponse à une requête peut sembler magique pour un non-spécialiste : « Waouh, ce robot sait tout ! ». Mais il n’y a pas vraiment de magie…

Tous les réseaux neuronaux fonctionnent plus ou moins de la même manière : un algorithme est créé et entraîné sur un ensemble de données, par exemple une série de photos de chats et de chiens, avec une description de ce qui est exactement représenté dans chaque image. Une fois que la phase d’apprentissage est terminée, l’algorithme reçoit une nouvelle image et doit déterminer s’il s’agit d’un chat ou d’un chien. Après ces modestes débuts, les développeurs de ces systèmes sont passés à un scénario plus complexe : l’algorithme entraîné sur de nombreuses photos de chats crée sur demande l’image d’un animal de compagnie qui n’a jamais existé. De telles expériences sont menées non seulement avec des images, mais aussi avec du texte, du contenu vidéo et même de la voix : nous avons déjà abordé le problème des deepfakes (où des vidéos modifiées numériquement de politiques ou de célébrités – pour la plupart – semblent dire des choses qu’ils n’ont jamais dites en réalité).

Pour tous les réseaux neuronaux, le point de départ est un ensemble de données d’apprentissage : les réseaux neuronaux ne peuvent pas inventer de nouvelles entités à partir de rien. Pour créer une image d’un chat, l’algorithme doit étudier des milliers de photographies ou de dessins réels de ces animaux. De nombreux arguments plaident en faveur du maintien de la confidentialité de ces données. Certaines d’entre elles sont dans le domaine public alors que d’autres sont la propriété intellectuelle de l’entreprise qui les a développées et qui a investi beaucoup de temps et d’efforts pour les créer dans l’espoir d’obtenir un avantage concurrentiel. D’autres encore constituent, par définition, des informations sensibles. Par exemple, des expériences sont en cours pour utiliser les réseaux neuronaux afin de diagnostiquer des maladies à partir de radiographies et d’autres examens médicaux. Cela signifie que les données d’entraînement algorithmique contiennent de véritables données sur la santé de personnes réelles qui, pour des raisons évidentes, ne doivent pas tomber entre de mauvaises mains.

Diffusion

Bien que les algorithmes d’apprentissage automatique se ressemblent pour un observateur extérieur, ils sont en fait différents. Dans leur article, les chercheurs accordent une attention particulière aux modèles de diffusion de l’apprentissage automatique. Ils fonctionnent de la manière suivante : les données d’entraînement (à nouveau des images de personnes, de voitures, de maisons, etc.) sont déformées par l’ajout de perturbations. Le réseau neuronal est ensuite entraîné à restaurer ces images à leur état d’origine. Cette méthode permet de générer des images de qualité convenable, mais un inconvénient potentiel (par rapport aux algorithmes des réseaux antagonistes génératifs, par exemple) est leur plus grande tendance à la fuite de données.

Les données d’origine peuvent en être extraites d’au moins trois façons différentes : d’abord, à l’aide de requêtes particulières, vous pouvez forcer le réseau neuronal à produire, non pas un résultat unique, généré à partir de milliers d’images, mais une image source spécifique. Deuxièmement, l’image originale peut être reconstruite même si seule une partie de celle-ci est disponible. Troisièmement, il est possible de déterminer simplement si une image donnée est contenue ou non dans les données d’apprentissage.

Très souvent, les réseaux neuronaux sont… paresseux, et au lieu de produire une nouvelle image, ils créent un résultat à partir de l’ensemble d’apprentissage si celui-ci contient plusieurs duplicatas de la même image. Outre l’exemple ci-dessus avec la photo d’Ann Graham Lotz, l’étude donne plusieurs autres résultats similaires :

Lignes impaires : images originales. Lignes paires : images générées par Stable Diffusion v1.4. Source.

Si une image est dupliquée plus de cent fois dans l’ensemble d’apprentissage, il y a de très fortes chances qu’elle ressorte sous sa forme quasi originale. Cependant, les chercheurs ont démontré qu’il était possible de récupérer des images d’entraînement qui ne figuraient qu’une seule fois dans l’ensemble d’origine. Cette méthode est beaucoup moins efficace : sur cinq cents images testées, l’algorithme n’en a recréé que trois au hasard. La méthode la plus sophistiquée pour attaquer un réseau neuronal consiste à recréer une image source à partir d’un simple fragment de celle-ci.

Les chercheurs ont demandé au réseau neuronal de compléter l’image après en avoir supprimé une partie. Cette procédure permet de déterminer avec une certaine précision si une image en particulier faisait partie de l’ensemble d’apprentissage. Si c’était le cas, l’algorithme d’apprentissage automatique générait une copie presque exacte de la photo ou du dessin original. Source.

À ce stade, intéressons-nous à la question des réseaux neuronaux et des droits d’auteur.

Qui a volé à qui ?

En janvier 2023, trois artistes ont poursuivi les créateurs de services de génération d’images utilisant des algorithmes d’apprentissage automatique. Ils ont affirmé (à juste titre) que les développeurs des réseaux neuronaux avaient utilisé des images collectées en ligne à des fins d’entraînement sans aucun respect du droit d’auteur. Un réseau neuronal peut en effet copier le style d’un artiste particulier et le priver ainsi de revenus. L’article laisse entendre que, dans certains cas, les algorithmes peuvent, pour diverses raisons, commettre un plagiat pur et simple, en générant des dessins, des photographies et d’autres images qui sont presque identiques au travail de personnes réelles.

L’étude propose des recommandations visant à renforcer la confidentialité de l’ensemble d’apprentissage original :

- Débarrassez-vous des doublons.

- Retraitez les images d’entraînement, par exemple en ajoutant des modifications ou en changeant la luminosité. Cette mesure réduit les risques de fuite de données.

- Testez l’algorithme en utilisant des images d’entraînement spéciales, puis vérifiez qu’il ne les reproduit pas à l’identique par inadvertance.

Et après ?

L’éthique et la légalité de l’art génératif constituent certainement un débat intéressant, dans lequel un équilibre doit être trouvé entre les artistes et les développeurs de la technologie. D’une part, le droit d’auteur doit être respecté. De l’autre, l’art informatique est-il si différent de l’art humain ? Dans les deux cas, les créateurs s’inspirent des travaux de leurs collègues et concurrents.

Mais revenons sur terre et abordons la question de la sécurité. L’article fournit un ensemble particulier de faits concernant un seul modèle d’apprentissage automatique. En étendant le concept à tous les algorithmes similaires, nous parvenons à une conclusion intéressante. Il n’est pas difficile d’imaginer un scénario dans lequel l’assistant intelligent d’un opérateur mobile distribuerait des informations confidentielles sur l’entreprise en réponse à une requête de l’utilisateur : après tout, elles figureraient dans les données d’entraînement. Ou, par exemple, une requête astucieuse pourrait tromper un réseau neuronal public et l’amener à générer une copie du passeport d’une personne. Les chercheurs soulignent que de tels problèmes restent théoriques pour le moment.

Mais d’autres problèmes se posent déjà. En ce moment même, le réseau neuronal de génération de texte ChatGPT est utilisé pour écrire de véritables codes malveillants qui fonctionnent (parfois). De plus, GitHub Copilot aide les programmeurs à écrire du code en utilisant un grand nombre de logiciels libres comme données d’entrée. Cet outil ne respecte pas toujours les droits d’auteur ni la vie privée des auteurs dont le code s’est retrouvé dans l’ensemble étendu de données d’apprentissage. Les réseaux neuronaux évoluent, tout comme les attaques dont ils font l’objet, avec des conséquences que personne ne comprend encore tout à fait.

réseaux neuronaux

réseaux neuronaux

Conseils

Conseils